ETL - co to jest?

- ETL – to musisz wiedzieć:

- Co to jest ETL?

- Jak działa proces ETL – trzy etapy

- Kiedy ETL, a kiedy streaming?

- Narzędzia ETL – przegląd ekosystemu i kryteria wyboru

- PIMCORE Datahub a ETL – importy/eksporty w praktyce

- Podsumowanie

- FAQ – Najczęściej zadawane pytania

ETL to dojrzała, wciąż fundamentalna metoda integracji informacji między systemami – od hurtowni danych, przez aplikacje biznesowe, po platformy martech. Z tego artykułu dowiesz się, co to jest ETL, kiedy warto go użyć (i kiedy lepiej sięgnąć po alternatywy), jak wygląda proces ETL krok po kroku, z jakich narzędzi skorzystać oraz jak przekuć te zasady na praktykę w module Datahub platformy PIMCORE.

ETL – to musisz wiedzieć:

- ETL (Extract, Transform, Load) to proces pobierania danych z różnych źródeł, ich przekształcania i ładowania do systemu docelowego, którego celem jest stworzenie spójnego, wysokiej jakości zbioru danych do analizy.

- Wybór między ETL, ELT a streamingiem zależy od potrzeb projektu: ETL sprawdza się przy złożonych transformacjach przed załadowaniem, ELT — gdy obliczenia wykonuje system docelowy (np. w chmurze), a streaming — gdy kluczowe jest przetwarzanie w czasie rzeczywistym.

- Narzędzia ETL obejmują zarówno rozwiązania open-source (Pentaho, Talend), jak i usługi chmurowe (AWS Glue, Azure Data Factory). Wybór zależy od skali danych, środowiska, budżetu i kompetencji zespołu.

- Dobre praktyki to m.in. wersjonowanie i testowanie procesów, wydzielanie stref danych (surowe, przetworzone), zapewnienie idempotencji oraz wdrożenie monitoringu i zabezpieczeń.

Co to jest ETL?

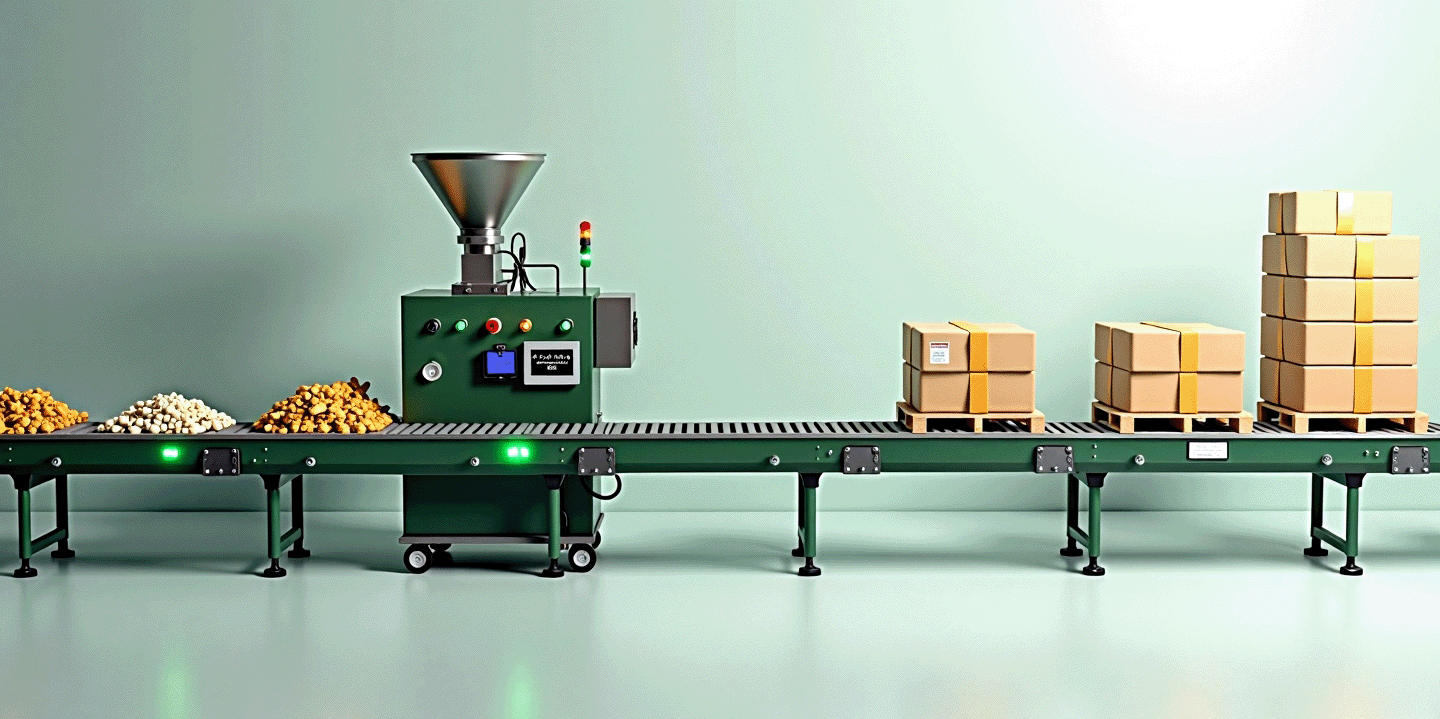

Skrót ETL oznacza Extract – Transform – Load, czyli kolejno: ekstrakcję, transformację i ładowanie danych. ETL to proces pobrania danych z jednego lub wielu źródeł (Extract), ich oczyszczenia, przekształcenia i dopasowania do wymagań celu (Transform), a następnie zapisania ich w systemie docelowym (Load). Celem jest spójny, wysokiej jakości zbiór informacji, gotowy do analityki, raportowania lub zasilania innych aplikacji. W literaturze branżowej ETL opisuje się jako klasyczną metodę integracji danych, stosowaną m.in. do budowy hurtowni danych czy zasilania jezior danych i aplikacji operacyjnych.

Często pada pytanie – ETL co to jest i czym różni się od nowszych podejść? ETL przekształca dane przed ich załadowaniem do celu, podczas gdy ELT robi to po załadowaniu (np. w chmurze lub w silniku DWH). Wybór zależy od architektury i wymagań projektu.

Jak działa proces ETL – trzy etapy

Extract – ekstrakcja

Pozyskujemy dane z plików (CSV, Excel, XML/JSON), baz relacyjnych/NoSQL, API, kolejek zdarzeń czy aplikacji SaaS. Ważna jest filtracja u źródła, obsługa przyrostów (np. Change Data Capture) i kontrola jakości.

Transform – transformacja

Oczyszczamy i ujednolicamy formaty (daty, waluty, kodowania), usuwamy duplikaty, mapujemy słowniki, łączymy tabele (join/lookup), wyliczamy pola pochodne, wzbogacamy rekordy (np. geokodowanie).

Load – ładowanie

Zapis do hurtowni danych, jeziora danych, bazy operacyjnej, aplikacji PIM/DAM/CRM – pełny lub przyrostowy. Dobrą praktyką są transakcje, walidacje po załadunku i ścieżki retry.

Tak opisany proces ETL to rdzeń większości potoków integracyjnych – niezależnie od technologii czy dostawcy chmury.

[Źródła] → Extract → [Strefa surowa] → Transform → [Strefa przetworzona] → Load → [System PIM/DWH/Datalake]

Kiedy ETL, a kiedy streaming?

Wybór odpowiedniego sposobu przepływu danych to strategiczna decyzja, która zależy od wielu czynników, m.in. złożoności transformacji, miejsca ich wykonywania, a także krytyczności i opóźnienia, jakie akceptuje Twój biznes. Odpowiedź na to pytanie często sprowadza się do wyważenia między potrzebą pełnej kontroli a koniecznością szybkiego działania. Sprawdź co i kiedy powinieneś wybrać:

- Wybierz ETL, gdy transformacje są złożone i chcesz je wykonywać poza systemem docelowym (np. zanim dane trafią do DWH/SaaS), masz wyraźnie zdefiniowane wsady i potrzebujesz ścisłej kontroli przepływu oraz jakości danych.

- Wybierz ELT, gdy „moc” obliczeniowa i narzędzia transformacji dostępne są w systemie docelowym (np. nowoczesne DWH/Lakehouse). Najpierw ładujesz dane, potem transformujesz je blisko magazynu.

- Wybierz streaming / near-real-time, gdy liczy się niska latencja – np. listingi produktowe, alerty, IoT, rekomendacje w czasie rzeczywistym. Usługi takie jak Google Cloud Dataflow (oparte o Apache Beam) lub natywne mechanizmy w chmurach potrafią obsłużyć zarówno wsady, jak i strumienie.

Narzędzia ETL – przegląd ekosystemu i kryteria wyboru

Na rynku znajdziesz zarówno rozwiązania „pudełkowe”, jak i open-source czy w pełni zarządzane usługi chmurowe. W praktyce narzędzia etl dobiera się do kontekstu, czyli środowiska (on-prem vs. chmura), skali danych, kompetencji zespołu, budżetu i wymagań dot. operacyjności (monitoring, SLA, wersjonowanie, IaC).

Przykładowe kategorie i reprezentanci (na podstawie oficjalnej dokumentacji):

Platformy Microsoft

SSIS – środowisko do budowy i wykonywania pakietów ETL w ekosystemie SQL Server/Azure. Dobre wsparcie dla konektorów, transformacji i orkiestracji.

Azure Data Factory – zarządzana usługa orkiestracji z przepływami danych (ETL/ELT), integracją z wieloma źródłami oraz triggerami i monitorowaniem.

AWS

AWS Glue – serverless usługa integracji danych; katalog metadanych, zadania ETL, orkiestracja, logowanie i integracje z jeziorami danych/DWH.

Google Cloud

Dataflow – zarządzony silnik dla wsadowych i strumieniowych potoków (ETL) oparty na Apache Beam; autoskalowanie, szablony i integracje z produktami GCP.

Open-source / dystrybucje

Apache NiFi – wizualne, stanowe „dataflow” do routingu, przetwarzania i mediacji systemów; dobre do przepływów czasu rzeczywistego i zarządzania kolejkami/priorytetami.

Pentaho Data Integration (Kettle) – klasyczne studio ETL z bogatym zestawem kroków i jobów; dostępne także w dystrybucji Hitachi Vantara.

Talend (Qlik Talend) – rozbudowana rodzina narzędzi do integracji i jakości danych (community i komercyjne edycje).

W realnych wdrożeniach ETL narzędzia często łączy się z orkiestratorami (np. harmonogramy w chmurze, narzędzia CI/CD) oraz observability (logi, metryki, alerty). W praktyce narzędzia ETL dzielą się na graficzne (drag-and-drop), skryptowe (Python/SQL/Beam) oraz usługi managed – każda ścieżka ma plusy i minusy (szybkość startu vs. elastyczność i wersjonowanie).

PIMCORE Datahub a ETL – importy/eksporty w praktyce

Pimcore 11 oferuje natywny moduł Datahub realizujący koncepcję ETL (Extract-Transform-Load) bez dodatkowych wtyczek. Datahub umożliwia import danych poprzez GraphQL, CSV, JSON, XML oraz RestAPI. W zakresie eksportu wersje CE i PE oferują API GraphQL, natomiast wersja EE dodatkowo wspiera eksport do formatów CSV, JSON, XML oraz RestAPI, pozwalając Pimcore działać jako platforma headless.

- Ekstrakcja i eksport danych Datahub udostępnia dedykowane endpointy GraphQL do pobierania danych z Pimcore (produkty PIM/MDM, treści CMS, pliki DAM). Klienci zewnętrzni precyzują w zapytaniach, jakie dane potrzebują, otrzymując je w formacie JSON. GraphQL pełni jednocześnie funkcję transformacji – struktura danych jest formowana już na etapie zapytania, eliminując nadmiarowe informacje.

- Import danych Datahub wspiera import poprzez mutacje GraphQL oraz graficzny Data Importer obsługujący pliki CSV, XLSX, JSON, XML. Administrator może mapować dane źródłowe na obiekty Pimcore, definiować transformacje i strategie aktualizacji bez programowania.

- Dystrybucja danych Oprócz API, Pimcore EE umożliwia eksport do plików (CSV, XML, JSON) z automatycznym dostarczaniem przez SFTP lub HTTP POST. Eksporty można planować cyklicznie lub wyzwalać zdarzeniami (webhooki).

Dzięki Datahub firmy usprawniają przepływ informacji bez pisania kodu, redukując koszty integracji i zwiększając elastyczność biznesową.

Podsumowanie

ETL to dojrzała, fundamentalna metoda integracji danych, która porządkuje i standaryzuje informacje w całej organizacji. Choć istnieją nowsze alternatywy, takie jak ELT i streaming, proces ETL pozostaje kluczowy dla zapewnienia wysokiej jakości danych, niezbędnych do analityki i sprawnego działania biznesu. Poprawne narzędzia ETL i wdrożenie dobrych praktyk projektowania są gwarancją, że procesy integracji danych będą niezawodne i skalowalne.

FAQ – Najczęściej zadawane pytania

ETL i ELT nie są tym samym, choć oba służą do integracji danych. Główna różnica polega na kolejności wykonywania transformacji. W procesie ETL dane są przekształcane przed załadowaniem do systemu docelowego (np. hurtowni danych). W procesie ELT (Extract, Load, Transform) dane są najpierw ładowane do celu (często do chmury lub nowoczesnego magazynu danych, jak data lake), a transformacje odbywają się dopiero tam, wykorzystując moc obliczeniową systemu docelowego.

Procesy ETL są powszechnie stosowane do zasilania hurtowni danych (DWH) na potrzeby raportowania i analityki biznesowej. Inne przykłady to migracja danych między systemami (np. z ERP do CRM), integracja danych z wielu źródeł (np. sprzedażowych, marketingowych i finansowych), czy zasilanie aplikacji operacyjnych, takich jak PIM/DAM, spójnymi danymi produktowymi.

Tak, Pimcore 11, dzięki wbudowanemu modułowi Datahub, umożliwia realizację procesów ETL bez pisania kodu. Narzędzie to pozwala na graficzne mapowanie danych źródłowych (z plików, API, GraphQL) na obiekty Pimcore, definiowanie transformacji i zarządzanie importami/eksportami w łatwy sposób. Umożliwia to także automatyzację i planowanie cyklicznych zadań.